2000 年ごろは、今のような SNS にぶら下がっていない個人運営の“ホームページ”がたくさんあり、すばらしいコンテンツ(小説やイラストなど)を公開していた当時のサイトもまたたくさんありました。それも今は昔、数多くのサイトが消滅してしまい、Google 検索をしても「404 Not Found」と表示されるか、検索すらできなくなってきています。懐かしくも寂しい話です。

そういった今はもう失われたサイトでも Internet Archive 1 で検索すれば、かつてのサイトの姿を見返すことができて大変便利……なのですが、表示のレスポンスはどうしても低速になりがちです。

そんなわけで Internet Archive に残っているデータを、Wayback Machine Downloader という Ruby の gem (ライブラリ) を使って、ローカル環境にたくさんのファイルをまとめて保存して、サクサク閲覧しようという内容の記事です。

小説のように、たくさんの HTML ページに分かれていたりするなら、おススメ。

環境構築

Windows らしい GUI アプリケーションがあれば手っ取り早いのですが、そういうわけにもいかないみたいなので、ちょうどいいプログラムを実行するための環境構築をします。

- Windows 10

- Visual Studio Code

- Ruby (gem version:2.2.1)

2020 年 8 月次点では

Ruby+Devkit 2.6.6-1 (x64)をインストールしました。

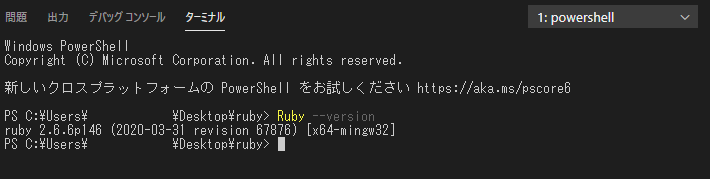

Ruby をインストールできたら、Visual Studio Code のターミナルを開いて (ctrl+shift+@)、シェルは Windows Power Shell で ruby 環境ができているか確認します。

ruby --version

こんな感じでなんらかのバージョンが表示されたら、環境構築は成功です。

Wayback Machine Downloader

さっそく、Internet Archive に残っているデータをダウンロードするライブラリをインストールします。

gem install wayback_machine_downloader

これにて準備完了です。

使い方

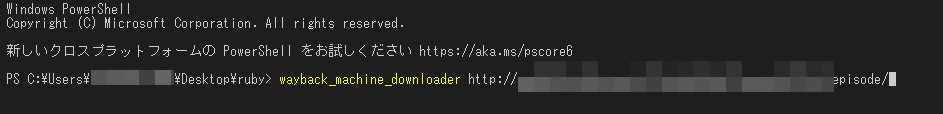

インストールに成功したら、Wayback Machine Downloader の使い方に従って、コマンドを実行します。基本的には以下のコマンドでよさそうです。

wayback_machine_downloader [URL]

URL はダウンロードしたいサイトの元々存在した URL です。もしも、時間指定やタイムスタンプが必要ならオプションを記述します。(詳細は GitHub の README.md 参照)

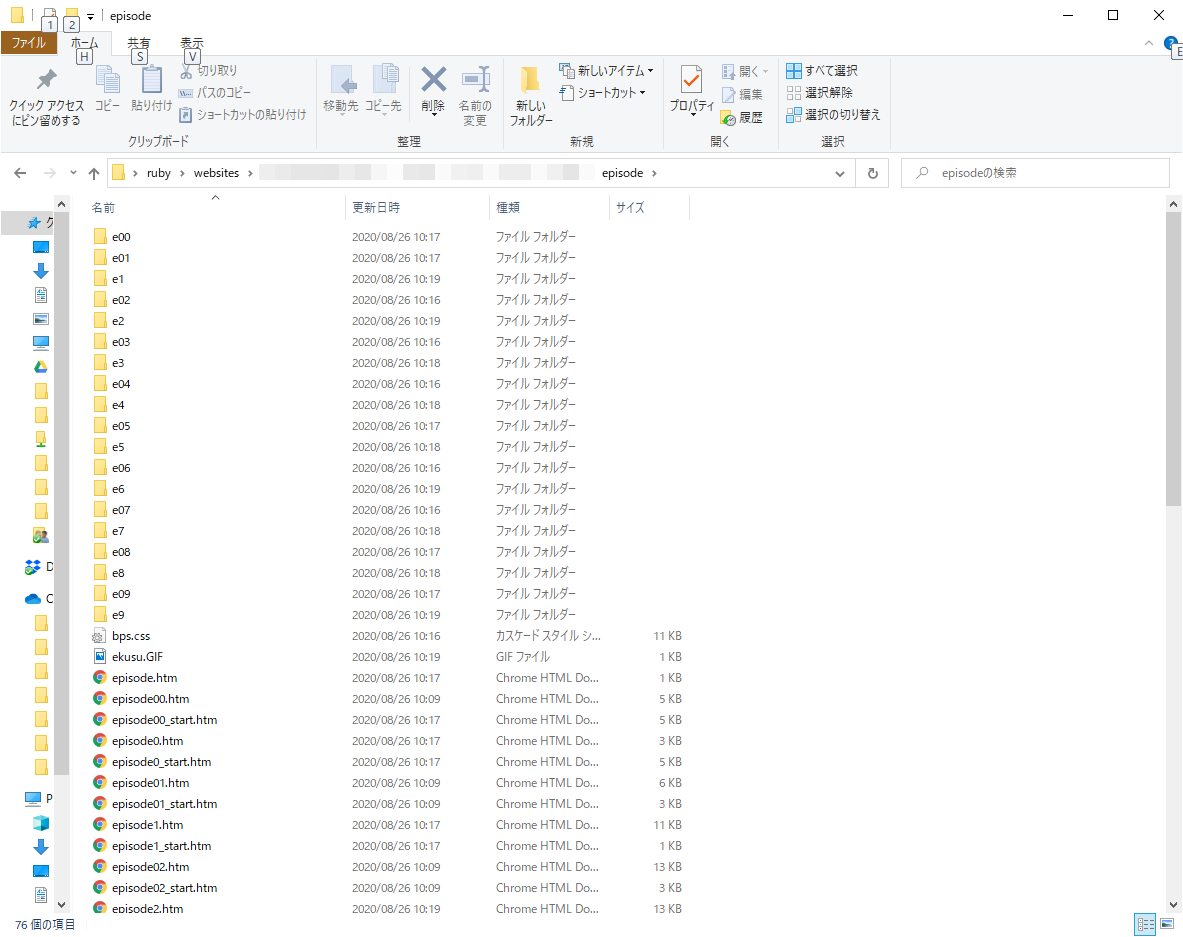

URL の最後が sample.html のようにすると、そのファイルだけしかダウンロードされません。まとめて処理するなら、URL を(上画像のように)ディレクトリーで指定するようにしましょう。含まれるファイルをまとめてダウンロードできました。(600個くらいまで確認しています)

備考

失わているサイトのデータを無許可に公開し直したり、だれかに再配布するのはやめておきましょう。故人であってもフリー素材じゃない。

著作物であるのはかわりないし、財産権と人格権の話は当然あるけど、そもそも著作権、財産権、人格権とか言い出す前のやつかと。個人で楽しむまででいいじゃないかと思います。

参考

- 作者:本間咲来

- 発売日: 2019/09/27

- メディア: 単行本

- 作者:まつもと ゆきひろ,David Flanagan

- 発売日: 2009/01/26

- メディア: 大型本

-

Internet Archive とは、世界中のサイトのアーカイブ閲覧サービスです。ある時点でのサイトのコピー(複製)を保存して、オンライン上で公開しています。↩